Fourier Position Embedding: Enhancing Attentions Periodic Extension for Length Generalization

Image credit: Original Paper

Image credit: Original Paper摘要

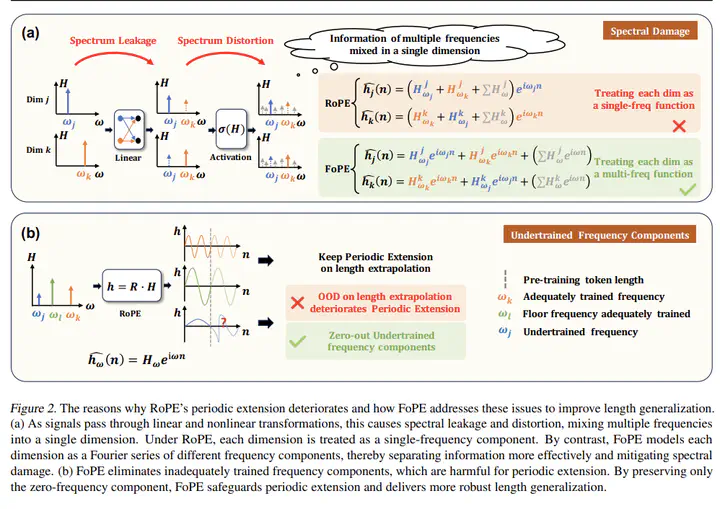

通过改进旋转位置编码(Rotary Position Embedding,RoPE)来扩展语言模型(Language Models,LMs)的上下文长度已成为一种趋势。然而,现有的研究主要集中在解决 RoPE 在 Attention 中的局限性,而本文则对语言模型的几乎所有模块都进行了分析,揭示了它们对 RoPE-based Attention 在长度泛化方面的不利影响。借助数字信号处理理论,我们证明了 RoPE-based Attention 隐式地使用了非均匀离散傅里叶变换,来实现周期性的 Attention 机制。然而,这种周期性受到了以下因素的破坏:1)Attention 机制之外的线性层和激活函数;2)由时域截断引入的未充分训练的频率分量。基于我们的观察,我们提出了傅里叶位置编码(Fourier Position Embedding,FoPE),它通过增强注意力的频域特性来改善其周期性延拓和长度泛化能力。FoPE 构建了傅里叶级数并消除了破坏性的频率分量,从而增强了模型对频谱损伤的鲁棒性。在不同模型规模和基准测试中的实验表明,在不同的上下文窗口中,FoPE 相比 RoPE 和 ALiBi 能够保持更稳定的性能。此外,多项分析和消融实验进一步支持了我们的方法和理论建模。

类型

出版物

ICML 2025